ხელოვნური ინტელექტის (AI) მიერ შექმნილი სხვადასხვა სახის კონტენტი, როგორებიცაა: ფოტო-ვიდეო მასალა, ტექსტი და სხვა, მუდმივ პროგრესს განიცდის. შესაბამისად, მისი ტექნიკა იმდენად დაიხვეწა, რომ ნამდვილი და AI-გენერირებული მასალის ერთმანეთისაგან გარჩევა რთულდება.

მიუხედავად ამისა, ჯერ მაინც რჩება გარკვეული მახასიათებლები, რაც AI გენერირებული მასალის გადამოწმების პროცესს ამარტივებს. მაგალითად, ხელოვნურ ინტელექტს ჯერ კიდევ უჭირს ადამიანის სხეულის ნაწილების - ხელების, ფეხების, თითების, აგრეთვე უკანა ფონზე არსებული ადამიანების სახეების თუ სხვა ობიექტების და ა.შ. სწორად გენერირება. ამ და სხვა კითხვებზე დეტალური ინფორმაციის მისაღებად „ფაქტ-მეტრი“ Deep Media-ს დაუკავშირდა და მის დირექტორ, რიჯულ გუპტას ესაუბრა. Deep media სინთეზური მედიის ამოცნობისა და მედია ანალიზის კომპანიაა, რომელიც აშშ-შია დაფუძნებული.

როგორ აგენერირებს ხელოვნური ინტელექტი ფოტოს?

როგორც გუპტა ამბობს, გამოსახულების გენერაციის მოდელები, როგორიცაა AI ხელოვნებაში გამოყენებული მოდელები, ხშირად ტრანსფორმერული არქიტექტურებისა და დიფუზიური მოდელების კომბინაციას ეყრდნობა.

ტრანსფორმერები გამოსახულებას ყოფენ უფრო მცირე ნაწილებად (მაგალითად, კვადრატებად), ამუშავებენ მათ და იგებენ, როგორ უკავშირდება პიქსელები ერთმანეთს. თუმცა ეს დაყოფა ზოგჯერ იწვევს შეუსაბამობებს, განსაკუთრებით ისეთ არეებში, როგორიცაა ხელები ან თითები. მოდელს შეიძლება გაუჭირდეს დეტალების შესაბამისობა სხვადასხვა ნაწილებს შორის, რაც იწვევს შეცდომებს, მაგალითად, ზედმეტ თითებს.

დიფუზიური მოდელები კი, პირიქით, მუშაობენ გამოსახულებაზე ხმაურის დამატებით და შემდეგ მის თანდათანობით მოშორებით. ეს პროცესი იმართება ტექსტური აღწერილობებით, რაც ეხმარება მოდელს, შექმნას საბოლოო გამოსახულება, რომელიც შეესაბამება მოცემულ ტექსტს. მიუხედავად იმისა, რომ ეს მოდელები კარგად ცნობენ მსხვილ ფიგურებს (როგორიცაა ადამიანის ფორმა), მათ შეიძლება გამოტოვონ პატარა დეტალები, როგორიცაა თითების სწორი რაოდენობა, რადგან ისინი დეტალებთან შედარებით უპირატესობას ფართო სიზუსტეს ანიჭებენ. ხელოვნურმა ინტელექტმა თუ მიიღო დავალება, შექმნას ადამიანის მოდელი, ისეთი დეტალები, როგორიცაა, მაგალითად, თითები მისთვის მეორეხარისხოვანია და პრიორიტეტი ადამიანის მთლიანი გამოსახულების შექმნაა.

მიუხედავად იმისა, რომ ხელოვნური ინტელექტი პროგრესს მუდმივად განიცდის, AI გენერირებული ფოტოების ამოცნობა ჯერჯერობით შესაძლებელია, ვინაიდან, როგორც ზემოთ აღვნიშნეთ, ის მცირე ხარვეზებით მუშაობს.

„ფაქტ-მეტრს“ ხელოვნური ინტელექტის მიერ გენერირებული ფოტომასალა არაერთხელ გადაუმოწმებია. მაგალითად, 2024 წლის მაისში სოციალურ ქსელში რომის პაპის ფოტოკოლაჟი გავრცელდა, რომელშიც რომის პაპს ლგბტ დროშა აქვს შემოხვეული. რეალურად, ფოტოები AI გენერირებული იყო, რასაც ვიზუალური დაკვირვებაც ცხადყოფს. ფოტოებზე შესამჩნევია, რომ დროშის ხაზების ფორმა და ფერი ერთმანეთს არ ემთხვევა. ამავდროულად, თუ გავითვალისწინებთ, რომ ხელოვნური ინტელექტი ადამიანის სახეს და სხეულის გარკვეულ ნაწილებს ზუსტად ვერ ქმნის, ფოტოს თუ კარგად დავაკვირდებით, შევამჩნევთ, რომ რომის პაპის კანი, განსაკუთრებით ხელებზე, საკმაოდ გლუვი და არაბუნებრივია.

რომის პაპი ყურადღების ცენტრში ხშირად ხვდება და სოციალურ ქსელებში მისი AI ფოტოებიც აქტიურად ვრცელდება. კიდევ ერთი მაგალითი ფოტოა (იხ. ქვემოთ), სადაც ის თითქოს როკ-მუსიკის ფანების დიდ ჯგუფთან ერთადაა გამოსახული და თავადაც მღერის.

თუ ფოტოს კარგად დავაკვირდებით, შევამჩნევთ, რომ ფონზე მყოფი ხალხის სახეები და კიდურები არაბუნებრივად გამოიყურება.

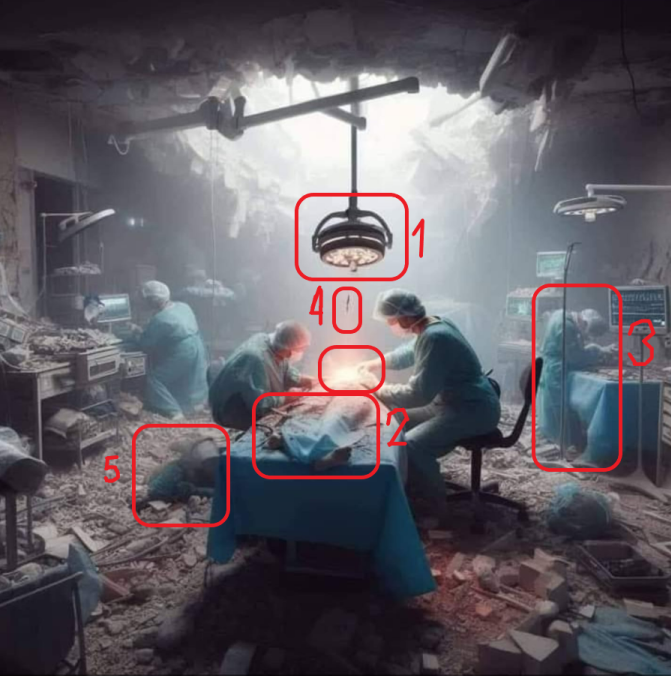

ხელოვნური ინტელექტის მასალაზე დაკვირვებისას მნიშვნელოვანია შუქჩრდილებზე დაკვირვებაც. მაგალითად, „ფაქტ-მეტრის“ არქივში მოიპოვება 2023 წლის ნოემბერში გავრცელებული ფოტოსურათი, რომელზეც თითქმის მთლიანად დანგრეულ საავადმყოფოში მიმდინარე სამედიცინო ოპერაცია იყო აღბეჭდილი. მას მოჰყვებოდა აღწერა, რომ ფოტო ღაზაში იყო გადაღებული.

იმაზე, რომ ფოტო ხელოვნური ინტელექტის (AI) მიერ არის შექმნილი, ფოტოზე არსებული შეუსაბამობები მეტყველებს. მაგალითად, ფოტოზე გამოსახულ პაციენტთან არსებული სინათლე, ლოგიკურად სანათიდან უნდა მომდინარეობდეს, თუმცა სანათი არ ანათებს, ან ისე მკაფიოდ არ ანათებს, როგორიც პაციენტზე არსებული სინათლის გამოსხივება საჭიროებს (1). ფოტოზე გამოსახული პაციენტი ასევე არაბუნებრივ პოზაშია (2), რადგან ფოტოს მიხედვით, მისი ერთი ფეხი, მეორე კიდურზე საგრძნობლად მოკლეა. არაბუნებრივია ფოტოს უკანა ფონზე გამოსახული ექთნების პოზიციაც (3). გარკვეული დეტალები კი სურათში ალოგიკურად ზის, მაგალითად, ფოტოს ცენტრში გამოსახული შავი ფერის ხაზი (4), ან ერთმანეთში ბუნდოვნად შერწყმული დეტალები (5).

რაც შეეხება ვიდეო და აუდიო მასალას. როგორც Deep media-ს დირექტორი რიჯულ გუპტა „ფაქტ-მეტრთან“ აცხადებს, ვიდეო და აუდიო კონტენტის ამოცნობა საკმაოდ გართულებულია, მათ შორის პროფესიონალებისთვისაც. არ არსებობს ერთი უნივერსალური ხელსაწყო ან ვებგვერდი, რაც საშუალებას მოგვცემდა, გადავამოწმოთ სასურველი კონტენტი და მასზე პასუხი 100%-იანი სიზუსტით მივიღოთ, სწორედ ამიტომ ექსპერტი თვლის, რომ ამ შემთხვევაში მნიშვნელოვანია კონტექსტის და შინაარსის გადამოწმება, რაზეც ვიდეო ან აუდიომასალა მოგვითხრობს. ასეთ შემთხვევებში მნიშვნელოვანია დაისვას კითხვები, რამდენად რეალისტურია ის, რასაც ვიდეოში ვხედავთ ან გვესმის, რამდენად ლოგიკურია, რომ ესა თუ ის პიროვნება ამა თუ იმ საკითხზე ამგვარად საუბრობდეს და ა.შ. „წარსულში ჩვენ ვცხოვრობდით საზოგადოებაში, სადაც ენდობოდნენ, მაგრამ ამოწმებდნენ, ახლა ჩვენ ვცხოვრობთ საზოგადოებაში, სადაც ამოწმებენ და მხოლოდ შემდეგ ენდობიან“, - აცხადებს Deepmedia-ს დირექტორი.

ხელოვნური ინტელექტის მიერ შექმნილი ვიდეო და აუდიომასალები რომ საინფორმაციო სანდოობისთვის გამოწვევაა, უკვე ბევრჯერ დადასტურდა. მაგალითად, AI მასალები რუსეთის უკრაინაში სრულმასშტაბიანი ომის კონტექსტშიც იქნა გამოყენებული. 2023 წლის ნოემბერში სოციალურ ქსელში იმ დროს უკრაინის შეიარაღებული ძალების მთავარსარდლის ვალერი ზალუჟნის ვიდეო გავრცელდა, სადაც ზალუჟნი ზელენსკის უკრაინის მტერს უწოდებდა და უკრაინელებს გადატრიალებისკენ მოუწოდებდა. ხელოვნური ინტელექტით გენერირებულ ე.წ. Deepfake ვიდეოებზეც შესაძლოა ხარვეზის პოვნა, მაგალითად, ტუჩებისა და თვალების არაბუნებრივი მოძრაობა, რაც ზალუჟნის ვიდეოშიც შეინიშნებოდა. თუმცა, უფრო მნიშვნელოვანი ამ შემთხვევაში ვიდეოში გაჟღერებული ინფორმაციის სანდო წყაროებში გადამოწმება იყო. ბუნებრივია, უკრაინის შეიარაღებული ძალების მთავარსარდლის მიერ გაკეთებულ მსგავსი განცხადება ნამდვილობის შემთხვევაში მაშინვე მიიქცევდა უკრაინული და საერთაშორისო მედიის ყურადღებას.

2024 წელს სლოვაკეთში საპრეზიდენტო არჩევნებამდე რამდენიმე დღით ადრე ინტერნეტში აუდიოჩანაწერი გავრცელდა, რომელშიც ერთ-ერთი პროდასავლური კანდიდატი ჟურნალისტთან საუბარში განიხილავდა არჩევნების გაყალბების სხვადასხვა ხერხს, მათ შორის, საზოგადოების ხმების ყიდვის სქემას. უცნობია, ზუსტად რა გავლენა ჰქონდა ხელოვნური ინტელექტით გენერირებულ ამ ყალბ ჩანაწერს არჩევნების შედეგებზე, თუმცა აღნიშნული კანდიდატი არჩევნებში დამარცხდა.

ხელოვნური ინტელექტით შექმნილი მასალები გამოჩნდა საქართველოშიც წინასაარჩევნო პერიოდში. 2024 წლის სექტემბერში საქართველოს პრეზიდენტის სალომე ზურაბიშვილის ვიდეო გავრცელდა, რომელშიც პრეზიდენტის ხმა რედაქტირებული იყო, კერძოდ, შეცვლილი იყო აუდიომასალა, რომელიც სალომე ზურაბიშვილის ბუნებრივ ხმასთან იყო მიმსგავსებული.

ასევე 2024 წლის სექტემბერში სოციალურ ქსელში ვლადიმირ პუტინის რედაქტირებული ვიდეო გავრცელდა, სადაც ის თითქოს ამბობდა, რომ აფხაზეთი საქართველოა. ვიდეოში პუტინის ტუჩების მოძრაობა საკმაოდ არაბუნებრივად გამოიყურებოდა. აღნიშნული ვიდეოს გადამოწმებისთვისაც მნიშვნელოვანი იყო ინფორმაციის სანდო წყაროებში გადამოწმებაც და კონტექსტის განხილვა, რამდენად გააკეთებდა რუსეთის პრეზიდენტი მსგავს განცხადებას.

რეკომენდაციები

როგორც AI გენერირებული მასალის, ასევე ზოგადად ნებისმიერი მედიაპროდუქტის თუ ინფორმაციის გადამოწმებისას, მნიშვნელოვანია შემდეგი კითხვების დასმა:

• ვინ დგას ინფორმაციის უკან? ვინ ავრცელებს ამ ინფორმაციას?

• ინფორმაციის დასადასტურებლად, რა მტკიცებულებებია მოცემული?

• რას ამბობენ სხვა წყაროები?

აღნიშნულ კითხვებზე პასუხის გაცემა სწორი ინფორმაციის დადგენაში დაგეხმარებათ. გადამოწმების გზებზე უფრო დეტალურად იხილეთ „ფაქტ-მეტრის“ მასალა.

უშუალოდ ხელოვნური ინტელექტით შექმნილი მასალის გადამოწმებისას, საჭიროა საკუთარ თავს შემდეგი კითხვები დავუსვათ:

• რამდენად ბუნებრივად გამოიყურება ადამიანის სახის ნაკვთები, სხეულის ფორმა, კიდურები, თითები?

• ფოტო/ვიდეოში გამოსახული ნივთები და ადამიანები ერთმანეთს არაბუნებრივად ხომ არ ერწყმის?

•მოიძებნება ფოტო/ვიდეოში ასახული მოვლენა ან ნათქვამი ინფორმაცია სხვადასხვა სანდო წყაროში?

• აუდიოს შემთხვევაში, დააკვირდით ხმის ხარვეზებს და შეუსაბამობებს, მაგალითად, საუბრის უცვლელ და უემოციო ტონს, არაბუნებრივ პაუზებს, უკანა ფონზე სტატიკურ ხმას.

• თუ ხმოვანი ჩანაწერს მხოლოდ არასანდო წყაროები ერთდროულად ავრცელებენ, შესაძლოა, აუდიო ხელოვნური ინტელექტით იყოს შექმნილი.

• ცდილობს ფოტო/ვიდეოს გამავრცელებელი შენში ბრაზის, შიშის ან აღფრთოვანების გაღვივებას?

• ფოტო/ვიდეო შენ ინფორმირებას ცდილობს თუ დარწმუნებას?